Aktuelles

FLEXI: Orientierungshilfe in Sachen lokales Hosting von LLMs

[03.07.2024]Wie umgehen mit KI in der Hochschullehre? Welche Zugänge sollten Hochschulen Lehrenden und Lernenden zentral zur Verfügung stellen? Im Rahmen des Projekts FLEXI (FernUni LLM Experimental Infrastructure) widmet sich Torsten Zesch mit einem interdisziplinären Team der Erprobung und Nutzung lokal betriebener Large Language Models (LLM).

Foto: Yuichiro Chino/Getty Images

Foto: Yuichiro Chino/Getty Images

Bisher kaum wissenschaftliche Studien

Das Potenzial, das Künstliche Intelligenz und insbesondere Large Language Models für die Hochschulbildung bieten, ist riesig. Solange aber Zugänge nicht über die Universitäten angeboten werden, nutzen Studierende wie Lehrende oft die kommerziellen Systeme ihrer Wahl. Damit einher gehen nicht nur potenzielle Probleme im Bereich des Datenschutzes oder der Kosten, sondern auch der Chancengerechtigkeit. Doch sollen für eine Hochschul-Lösung kommerzielle Dienste wie ChatGPT genutzt oder ein Open-Source-Modell selbst gehosted werden? Die FernUniversität in Hagen exploriert beide Wege. FLEXI ist dabei die Open-Source-Lösung. „Durch den Reallabor-Ansatz unseres Forschungszentrums können wir FLEXI im echten Einsatz testen“, erklärt Torsten Zesch. Und zwar nicht nur technisch: CATALPA begleitet verschiedene Einsatzszenarien mit Forschungsprojekten. „Bisher gibt es kaum Evidenz zur Auswirkung von Large-Language-Models auf die Lehre“, so Zesch. Das Ziel von FLEXI lautet darum: Dringend benötigte, wissenschaftlich fundierte Erkenntnisse zur Nutzung dieser lokalen Lösungen.

Cloud vs. Lokal

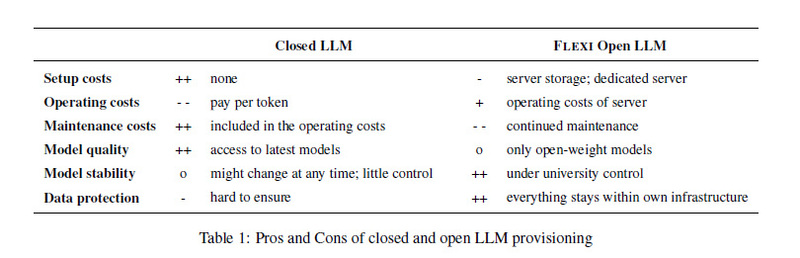

Für die Experimentierumgebung in Rahmen von FLEXI hatten die Forschenden die Wahl zwischen einem lokal gehosteten, offenen LLM oder der Cloud-basierten Variante. „Cloud-basierte Systeme sind einfach zu nutzen und stellen sicher, dass die leistungsfähigsten Modelle zur Verfügung stehen. Offene LLMs sind derzeit dafür kosteneffektiver und der Datenschutz ist deutlich leichter sicherzustellen. Aus diesen Gründen haben wir uns für offene LLMs an der FernUni entschieden“, erklärt Zesch. „Mit FLEXI konnten wir erfolgreich demonstrieren, dass es möglich ist, eine generative KI an der Hochschule selbst zu betreiben”, so Wirtschaftsinformatiker Michael Hanses, der die Lösung maßgeblich technisch aufgesetzt hat. FLEXI soll das Experimentieren mit lokal gehosteten, offenen Large Language Models sowohl in der Lehre als auch in der Wissenschaft ermöglichen.

Foto: CATALPA

Foto: CATALPAPraktische Orientierungshilfen

Mit einer neuen Veröffentlichung geben die CATALPA-Mitglieder Torsten Zesch, Michael Hanses, Niels Seidel, Piush Aggarwal, Dirk Veiel und Claudia de Witt Hochschulen in der Findungsphase praktische Orientierungshilfen für den Betrieb eines eigenen LLM-Servers. Denn zum Zeitpunkt der Veröffentlichung des Papers gibt es allein 90 verschiedene Modelle, aus denen man wählen kann – alle mit ihren eigenen Stärken und Schwächen. Im Paper zeigen Zesch und seine Co-Autor*innen, anhand welcher Kriterien sie die Modelle ausgewählt haben, welchen Qualitätstests sie diese unterzogen haben und welche Use Cases sie gerade entwickeln.

„Wir müssen die Hochschullandschaft nicht nur darin unterstützen, Zugänge zu KI und LLMs zu schaffen, sondern auch kritisch hinterfragen, wie die Technologie tatsächlich Mehrwert für das Lernen und Lehren bietet“, lautet das Fazit von Torsten Zesch.

KI-Experimentierumgebung

Das Projekt FLEXI entstand als Teil der Experimentierumgebung an der FernUniversität in Hagen. Das ZLI startete zusammen mit CATALPA mit einer KI-Experimentierumgebung, die sowohl ChatGPT als auch anpassbare OpenSource-LLMs (Large Language Models) umfasst. Lehrende sind dazu aufgerufen, sich an der Experimentierumgebung zu beteiligen und zusammen mit den Projektpartnern im kommenden Wintersemester verschiedene Szenarien auszuprobieren.